原本以為只是一則兩小時的影片,沒想到其實背後是一系列的課程。

由於共學的重點在學習 fast.ai 的各式應用,倫理部分就由我簡單帶過,介紹一些基本概念,以及到哪裡尋找相關資訊。

大公司做 AI 一定會配置 AI 倫理工程師,其實是蠻獨特的工作機會。

我個人認為,你的碩士論文如果是這個領域,在初期會有些許優勢。

又因為未來可能要代表公司參加相關研討會,上不上相、口條好不好,也是很重要的門檻。

課程介紹

這個主題 fast.ai 總共有六堂課,其中第四堂課有兩段影片、第五堂課有三段影片,所以總共九段影片。

課程內容

-

虛假資訊 Disinformation

-

偏見與公平 Bias & Fairness

-

道德基礎與實用工具 Ethical Foundations & Practical Tools

-

隱私和監控 Privacy & surveillance

-

我們的生態系:指標、創投與捨本逐末 Our Ecosystem: Metrics, Venture Capital, & Losing the Forest for the Trees

-

算法殖民主義與後續步驟 Algorithmic Colonialism, and Next Steps

資料來源:

課程大綱

資料來源:

推薦閱讀

官方論壇專區

正文

如果你只有五分鐘,請記住以下三種案例:

反饋迴圈(Feedback Loop):模型控制的下一輪資料可能有缺陷,常見的範例是推薦系統。

The Toxic Potential of YouTube’s Feedback Loop | WIRED演算法偏見:錯誤的演算法,導致原本應該獲得補助的病友,拿不到補助。

fast.ai - What HBR Gets Wrong About Algorithms and Bias廣告系統歧視:非裔姓氏導致的犯罪歧視

Racism is Poisoning Online Ad Delivery, Says Harvard Professor | MIT Technology Review

FAT framework: Fairness, Accountability, and Transparency(公平、責任和透明度)

我們都知道軟體可能有錯誤,我們的程式碼可能會以意想不到的方式運行,我們需要為此做好準備。

科技可以用來造成傷害,而且是非常可怕的傷害。

如果你發現你是最終損害社會的系統的一部分?你會有何感受?

你知道嗎?

你是否願意了解如何你建造的東西可能有害?

你如何確保這種情況不會發生?

IBM 賣電腦給納粹的故事。

道德是處理善惡的學科。

這是一套道德原則。不是一組答案,

但它正在學習要問什麼問題,甚至如何權衡這些決定。

這是一個永無止境的學習實踐道德智慧的過程。

幾篇參考文章:

來自聖克拉拉大學馬庫拉技術倫理中心。

特別是 Shannon Valor、Brian Greene 的作品,Irina Raykou 非常棒,他們有很多資源

凱西·菲斯勒是科羅拉多大學教授,她創建了一份技術道德教學大綱的眾包電子表格。

此眾包電子表格中輸入了 200 個教學大綱,然後對它們做了薈萃分析

如何最好地教授技術道德的問題正在進行中,但缺乏共識。

它應該是一個獨立的課程還是融入課程中的每一門課程?

誰該教它?

電腦科學家、哲學家還是社會學家?

她分析了教學大綱,課程之家和導師之家是什麼?

講師來自不同的課程,包括一系列學科:電腦科學、資訊科學、哲學、科學技術研究、工程、法律、數學、商業。

要涵蓋哪些主題?

這顯然超出了任何內容所能涵蓋的範圍,這是一個達成更多共識的領域。

我們課程試圖教導的首要技能是批評,其次是發現問題、提出論點。

所以很多事情只是學習發現問題是什麼以及如何解決。批判性地評估一項技術或設計方案,可能會出現什麼問題以及可能有哪些風險。

我將分享三種不同的道德

案例分享一:幫派成員資料庫

資料庫的程式錯誤(只能加、不能減)

加州使用一個資料庫來追蹤所謂的幫派成員。

審計員發現資料庫有 42 位一歲以下的嬰兒。

而這個資料庫從不更新。意思是:可以添加人員,但從未刪除。

所以一旦被加進資料庫,就永遠在資料庫中。

其中 28 名嬰兒,被標記為 承認自己是幫派成員。

請記住:這是一個非常明顯的錯誤範例。但還有多少其它我們未發現,不明顯但卻完全錯誤的項目呢?

案例分享二:信用調查報告

資料庫內容錯誤

FTC 對信用調查報告的大規模研究發現,26% 的報告中,至少存在一個錯誤。其中 5% 的人,存在可能具有毀滅性的錯誤。

以下是一個公共廣播記者寫的,他買公寓的經歷。

他要買一間房子,但屋主告訴他,經過背景調查,顯示他有槍支定罪的犯罪記錄。

但事實上他從未有過犯罪記錄。

而且在大部分的情形下,房東可能不會告訴你不賣給你的原因。

身為記者,他為此事展開相關調查。

記者的身份,讓他可以訪問到相關的負責人,找出信用調查報告的問題,加以解決。

如果是一般人呢?

案例分享三:臉部識別的誤用

資料庫可能正確無誤,但使用者錯誤使用

臉部識別大部分是為成年人開發的。

然而,紐約警察局將年僅 11 歲的兒童照片加入資料庫,這會導致錯誤率更高。

所以這是一個嚴重的問題。並且存在許多誤用。

喬治城隱私和技術中心非常棒。

他們做了一份報告, GIGO - Garbage In, Garbage Out(垃圾進,垃圾出)。

研究警察在實際工作中,如何使用臉部辨識。他們發現了一些令人擔憂的例子。

例如,在某些情況下,紐約警察局有嫌疑犯的照片,但沒有返回任何符合對象。

他們覺得這個嫌疑犯看起來像伍迪哈里森。

然後他們用谷歌搜尋了這位演員,把他的臉放在臉部辨識中,用它來搜尋資料庫中是否有符合的對象。

顯然這根本不是正確的用法,但這是紐約警察局的一種實際使用方式。

回饋循環和指標

指標對於人工智慧來說是一個大問題。人工智慧和機器學習的大部分內容都集中在優化指標上,這都是機器的強項。

但過度強調指標可能會導致許多問題,包括操縱、遊戲、短視地專注於短期目標,因為追蹤短期目標更容易。

機器學習的強項是它真的非常擅長優化指標,但這本質上也是一個弱點或限制。

範例一:能衡量的才是重要的

https://doi.org/10.1111/j.1467-9299.2006.00600.x

這是一項關於英國公共衛生系統何時實施了許多措施的研究,大約在 2,000 年代初期。

這項研究被稱為「能衡量的才是重要的」(What’s Measured is What Matters)。

目標之一是 減少急診室等待時間,這似乎是一個不錯的目標。

但指標定為減少急診室等待時間後,醫院的因應措施是減少日常的開刀,以便將醫生空出來處理急診室的病患。

然後救護車(派出)抵達病患地點的時間也延長了,因為在救護車回到醫院之前的時間,不列入急診室等待時間。

最後就是將擔架放在走廊上,將其變成床,因為這樣也不算在急診室等待時間。

所以,你分別問醫院和病人,急診室等待時間的長短,會得到截然不同的答案。

範例二:論文評分軟體

這個作文評分軟體,現在美國有 22 個州正在使用。

它傾向於關注句子長度、詞彙量、拼字等指標,但無法評價諸如創造力或新穎性之類的東西。

複雜的單字得分很高,然而,亂七八糟的文章很多。

而且它們甚至是由人撰寫程式來產生這些胡言亂語、複雜的文章,然後由另一個計算機程式評分並獲得高度評價。

這個系統也存在偏見:

-

非裔美國學生的論文,計算機的評分低於人工評分專家的評分。

-

中國學生的論文,計算機給出的分數比人類專家評分者給的分數更高。

這項研究的作者認為,這一結果表明中國學生可能使用預先記憶的大範圍文字,得分很高。

這就是 古德哈特定律,很多人都在談論的定律。你越依賴一個指標,它就會變得越不可靠。

範例三:推薦系統

回到回饋循環和推薦的範例

Guillaume Chaslot 是前 YouTube 系統工程師(YouTube 歸谷歌所有)。他寫了一篇文章,關於 YouTube 早期推薦系統,目的在最大化用戶觀看時間。

這是指標中經常發生的事,即任何指標只是你真正關心的事情的代表。在這裡,谷歌的團隊認為,如果使用者看更多 YouTube,表示用戶更樂於觀看。

YouTube 似乎更重視最大化觀看時間,而不是按讚(用戶喜歡)。

結果就是:推薦系統鼓勵使用者,在平台上花費更多時間。

他與《華爾街日報》的《衛報》合作調查,試圖從外部監控 YouTube 的推薦,並成立了非營利組織 Algo 提高透明度。

這不僅僅是 YouTube,任何推薦系統都可能受到類似的影響。

影片提供者,可能透過某些不正當的方法,即使是不正確的資訊,只要能提高觀看時間、瀏覽量,就會被推薦系統推薦。

例如以下這篇文章提到的: 地球是平的、教宗方濟各是邪惡的、 米歇爾歐巴馬(前美國總統夫人)其實是男的…

這是需要注意的事情,這可能是推薦系統的創造者沒有預料到的。

平台就是訊息

我們的許多激勵措施都集中在短期指標上,長期的事情要困難得多,要衡量經常涉及複雜的關係。

大多數科技公司的基本商業模式,都是圍繞操縱人們的行為,並壟斷他們的時間。

廣告本質上不是不好,但如果走向極端,它可能會產生負面影響。

詹姆斯·格里馬爾曼 (James Grimalman) 寫了一篇論文,談論平台之間的競爭,被病毒式傳播的原因。

提供令人憤慨和反感的內容,在許多情況下受大量觀看並得到推廣,並以 Tide Pod Challenge 影片為例。

主要的技術平台經常激勵和宣揚虛假訊息,而且是無意的,

閃電式擴張

閃電式擴張的想法,前提是如果一家公司成長夠大、夠快,利潤最終會隨之而來。

他們的推薦系統,最終是他們的商業模式。

它優先考慮速度而不是效率,並可能面臨災難性失敗的風險。

Tim O’Reilly 寫了一篇非常棒的文章:

這種方法非常普遍,是許多創投的基本模型。

投資者最終會指定贏家,而不是市場力量。

它往往有利於創造壟斷和雙頭壟斷。

這對創始人來說是不利的,而且人們最終會過度分散自己。

因此,這有許多重大的缺點。

為什麼要在道德課上提到這一點?

當我們談論指標時,速度高於一切,沒有時間反思道德,

如果你的擴張速度非常快,遵循這個模型,當你確實遇到問題時,它通常會大規模地出現。

緬甸的種族滅絕

聯合國調查人員引述,穆斯林少數民族羅興亞人正在經歷種族滅絕,Facebook 在傳播仇恨言論方面發揮了作用。

https://www.reuters.com/article/us-myanmar-rohingya-facebook-idUSKCN1GO2PN

自 2017年8月叛亂分子襲擊引發安全鎮壓以來,已有超過 65 萬穆斯林少數民族羅興亞人,逃離緬甸若開邦進入孟加拉。許多人提供了緬甸安全部隊處決和強暴的悲慘證詞。

聯合國人權事務高級專員上週表示,他強烈懷疑發生了種族滅絕行為。緬甸國家安全顧問要求提供「明確證據」。

聯合國緬甸獨立國際實況調查團主席馬祖基·達魯斯曼告訴記者,社群媒體在緬甸發揮了「決定性作用」。

「如果你願意的話,它極大地加劇了公眾內部的尖酸刻薄、分歧和衝突。仇恨言論當然是其中的一部分。就緬甸局勢而言,社交媒體就是Facebook,Facebook就是社交媒體。”

聯合國緬甸調查員李亮熙表示,Facebook 是公共、公民和私人生活的重要組成部分,政府利用它向公眾傳播訊息。

「在緬甸,一切都是透過 Facebook 完成的,」她告訴記者,並補充說 Facebook 幫助了這個貧困國家,但也被用來傳播仇恨言論。

WhatsApp 充斥著巴西大選假新聞

https://www.reuters.com/article/us-brazil-election-whatsapp-explainer-idUSKCN1MU0UP

2018年10 月的巴西總統選舉前,Facebook 曾大力宣傳其主要平台上打擊虛假信息的努力,但 WhatsApp 卻充斥著謊言和陰謀論。

WhatsApp 在擁有近 2.1 億人口的巴西擁有超過 1.2 億用戶。

虛假謠言、篡改照片、影片惡作劇已成為競選彈藥,在平台上瘋傳,但無法監控其來源或影響範圍。

Facebook 假錯誤訊息與菲律賓選舉

上述文章發表日期為 2021年11月22日,2022年總統當選人為小馬可仕。

巨魔(The Trolls):在童話故事中,巨魔是一種憤怒、反社會的怪物,躲在橋下準備搶走一隻名叫比利的山羊。

網路巨魔不是躲在橋下,而是躲在電腦或手機後面,不遺餘力地在網路上製造痛苦。

超過 90%的菲律賓人使用社群媒體上網。Facebook 和 YouTube 在該國佔據主導地位:截至 2021 年,約 81% 的菲律賓人口使用 Facebook。同時,85% 可以上網的菲律賓人觀看 YouTube。

菲律賓網路使用者平均每天在社群媒體上花費近四小時。

2017 年的一項調查發現,能夠上網的菲律賓人比主流媒體更信任社群媒體。其中 87% 的受訪者聲稱信任社群媒體上的資訊。

巨魔(The Trolls)在菲律賓網路上發布煽動性內容,以引起關注。

他們聚集在 Facebook 等網路空間上傳播錯誤訊息,有時會聯合起來組成「錯誤訊息大軍」或「巨魔大軍」。通常,這些巨魔甚至不是真人。

巨魔傳播的假訊息不僅限於新聞源。WhatsApp、Viber 和 Facebook Messenger 等即時通訊應用程式是假新聞和錯誤訊息的主要平台。由於它們是私人互動,因此比 Facebook 主要平台更難監管。

總統羅德里戈·杜特蒂的競選活動是菲律賓第一個利用社群媒體病毒式傳播的活動。在他的社群媒體經理尼克·加布納達(Nic Gabunada) 的指示下,杜特蒂的競選活動僱傭了一支網路巨魔大軍,其任務是在整個菲律賓網路空間「放大」他的訊息。

這些巨魔為杜特蒂進行宣傳,並繼續散佈支持其政策的訊息。

2016 年是菲律賓首次《社群媒體選舉》,競爭激烈的 2022 年選舉可能會成為更戲劇性的第二幕。在杜特蒂的社群媒體運動取得令人震驚的成功之後,錯誤訊息在菲律賓社會中根深蒂固。

Covid-19 大流行加劇了這種情況,期間錯誤訊息對政府公共衛生措施構成了威脅。網路噴子如今已成為菲律賓網路空間的普遍現象:公司、名人和政客都使用網路噴子來抹黑對手或製造狂熱粉絲的形象。他們經常被政客僱用來為他們而戰。

通常,他們會透過「真人」的推文來製造支持的假象。受僱的網路噴子團隊透過多張 SIM 卡和社群媒體帳號冒充真人,以放大和傳播錯誤訊息,同時壓制反對意見。

憤怒、病毒式傳播、錯誤訊息和惡搞之間的適當平衡可能足以使天平向任何候選人傾斜。

偏見和假資訊

當我們談論道德時,其中有多少是故意的、不道德的行為?

講師認為很多例子是無能的行為或糟糕的建模,無論是產品或模型,未經充分測試就匆匆上市。圍繞偏見,但不一定是惡意的。大部分都是無意的。

在很多情況下,利潤激勵是錯置的。

當人們賺了很多錢,很難會考慮減少他們利潤的行動,即使它們可以防止傷害並提高道德。

更重視利潤,而不是人們受到的傷害。

大部分的人並不想引發種族滅絕,或者幫一位獨裁領導人當選。

至少開始時不是。

有道德的經營者,知道自己對此負有責任,應該做得更多。

關於偏見的討論,Harini Suresh 和 John Goutag 發表了一篇很棒的論文(以下連結分分為文章介紹和論文 pdf,講師極力推崇這麼做,畢竟論文的門檻比較高,同步發表文章,有助理論的推廣)。

上述的論文中對不同類型的偏見進行分類,講師介紹了其中一種: 代表性偏差(representation bias)。

Joy Buolamwini 是麻省理工學院的研究員,研究電腦視覺系統中的演算法偏差。

她在麻省理工學院的論文揭示了微軟、IBM 和亞馬遜等公司,在人工智慧服務中存在的種族和性別偏見。

她們(Joy Buolamwini & Timnet Gebrouw)發現,臉部識別的產品,基本上的結果都是:女性比男性糟糕、深色皮膚比淺色皮膚糟糕。

以 IBM 為例,其產品對淺膚色男性的準確率達到 99.7%,對深色皮膚女性的準確率只有 60% - 95%。

解決這個問題的方法是建立一個更具代表性的資料集。

幾年前,所有流行的臉部資料集都是淺膚色男性,例如 IGBA,一個流行的臉部資料集。只有 4% 的圖像是深色皮膚的女性。

看起來這是一個可以透過科技解決的問題,但並非所有問題都是。

ImageNet 可能是目前研究最廣泛的電腦視覺資料集。

其中三分之二的 ImageNet 影像來自西方。45% 的圖像來自美國,7% 來自英國,6% 來自義大利,3% 來自加拿大,3% 來自澳洲。

這一點在 ImageNet 上訓練的分類器得到了體現。

其中一類是新郎,因為新郎服飾有很多文化成分,所以他們的錯誤率高很多。

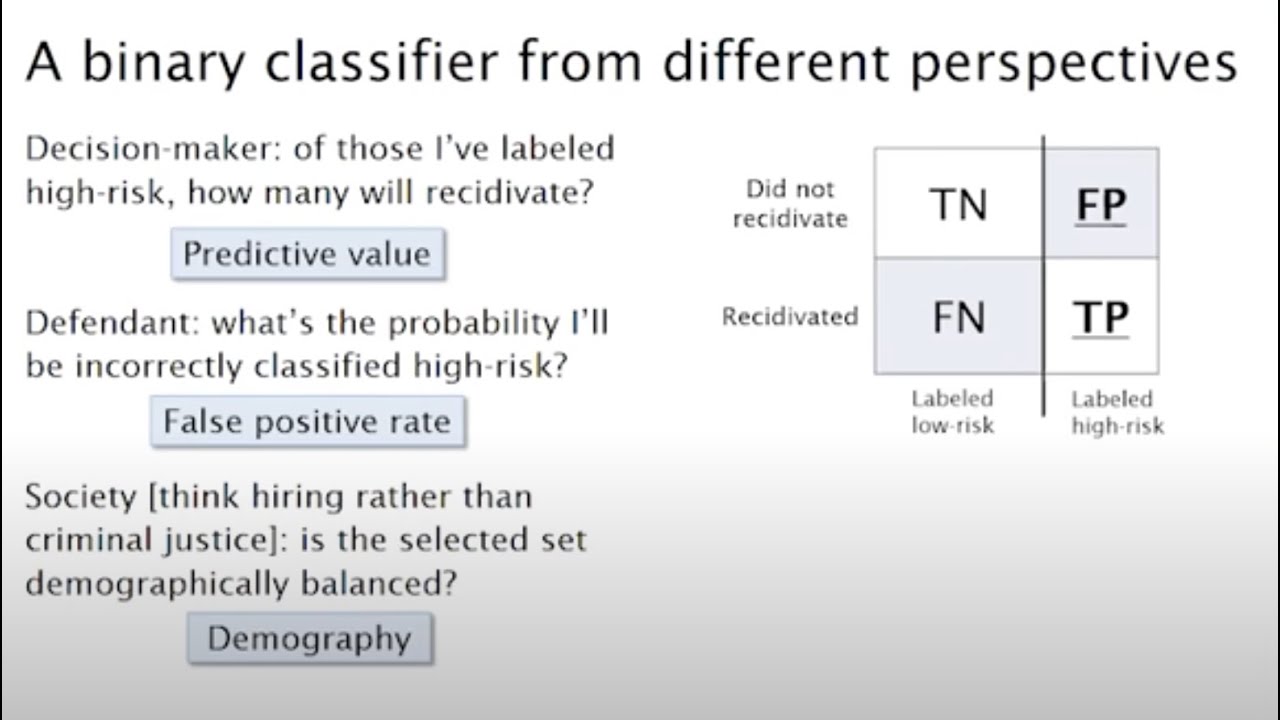

案例 COMPAS:累犯演算法

累犯演算法,COMPAS 的使用,該軟體用於向法官就是否應給予被告審前釋放提出建議。

在美國,有很多在監獄裡甚至還沒有接受審判的人,該演算法決定支付保釋金以及量刑決定和假釋。

ProPublica 在 2016 年做了一項著名的調查,發現黑人被告的誤報率,幾乎是白人被告的兩倍。

許多州仍然在使用這套有問題的演算法,例如威斯康辛州。

Arvin, Naranyan 有個很棒的教程:21 fairness definitions and their politics(21個公平定義及其方針),強烈推薦。

如果你沒空看完上述將近一小時的影片,這裡有別人整理好的筆記:

回到類型分類法,這是歷史偏見的例子。

歷史偏見是一個根本的,資料生成過程第一步的結構問題,即使給定完美的取樣和特徵選擇,它也可以存在。

所以有了圖像分類器,這就是我們可以做的事情。收集一組更具代表性的圖像,這將有助於解決這個問題。

這裡情況不同。

司法系統,這一切都會有偏見,因為那是真正融入了我們的歷史和現狀。

認識到這一點是件好事。可以嘗試至少減輕這種情況,就是與領域專家和受影響的人進行真正的對話。

這是一個正面的例子,來自公平、問責和透明度會議的教程。

Christian Lum(人權資料分析小組首席統計學家,現為賓州大學教授)與 Elizabeth Bender(紐約法律扶助協會前公設辯護人)一起組織了 Accountability and Transparency Conference。

協助一名無辜者 Terence Wilkerson,被捕後無力保釋。

人工智慧的偏見不是從你的生活偏見中轉移過來的嗎?

人們如何不同對待女性,也是一種日常現象。所以這通常是來自現實世界的偏見。

但演算法系統會放大這些偏見,使情況變得更糟。它們通常是從現有數據中學習的。

我問這個是因為我想我常常看到,有人提出這個問題,就好像這是一個不用擔心人工智慧的理由。

測量偏差

Sendhil Mullainathan 和 Ziad Obermeyer 的一篇論文(找不到該論文,附上一些訪談作參考)。

https://www.nejm.org/doi/full/10.1056/NEJMp2301936

他們查看歷史電子健康記錄數據,試圖確定哪些因素最能預測中風。

他們發現排名第一的預測因素是既往中風(曾中風過),這是有道理的。

其次是心血管疾病。

第三個最重要的、仍然非常有預測性的因素是意外傷害。

再其次是良性乳房腫塊、大腸鏡檢查或鼻竇炎。

雖然我不是醫生,但我可以看出第三到第六因素發生了一些奇怪的事情,為什麼這些東西可以預測中風?

有誰想思考為什麼會這樣?

第一個答案是他們會在有人中風時進行測試。

確認偏差、過度擬合、是因為他們剛好已經住院了嗎?

研究人員在這裡所說的是,這是關於他們的病人、經常使用醫療保健的人和不經常使用醫療保健的人,他們稱之為醫療保健的高效用與低效用。

基本上,經常使用健保的人,他們會在有狀況時去看醫生,鼻竇炎,中風時也會進去。

不用健保的人,很多人就不會有資料。

前面提過,人們不是有偏見嗎?

對此已有數十項甚至數百項研究。所有這些都與 Sendhil Mullainathan《紐約時報》文章有關,如果你想尋找相關研究。

黑人患者與白人患者相比(相同文件,只有病人的種族不同)、二手車的初始價格、公寓租賃廣告,黑人名字引起的反應比白人名字少、陪審團中的種族比例,讓黑人被告更有可能被定罪。

我之所以分享這些,是為了表明無論你正在處理什麼類型的數據,無論是醫療數據、銷售數據、住房數據或刑事司法數據,很可能有偏見。

演算法偏差

我將分享四個原因。

機器學習會放大偏見

這不僅是對現有偏見的編碼,而且在某些情況下還使它們變得更糟。

關於這一點已經有一些研究,我喜歡的一位來自 CMU 的 Maria de Artiga。

她從 LinkedIn 上取得人們的職位描述。

在外科醫生群體中,只有 14% 是女性。

當她試著從摘要預測職位名稱,女性的正確率僅 11%。

所以這種不對稱性變得更加嚴重。

演算法了解到,對於女性來說,不要猜測外科醫生會更安全。

實務中,演算法的使用與人類決策者的使用非常不同

在很多情況下,我認為演算法系統的實施並不是因為它們能為每個人帶來更好的結果,只因為它們是一種更便宜的大規模做事方式。

提供追索流程的成本更高。

尋找錯誤的成本更高。

所以這是削減成本的措施。

尋求不同領域的意見

如果您正在建立 ML 產品,您會就此向學術機構諮詢嗎?

您是否看到數據產品開發,加入道德或資料隱私專家?

總的來說,來自更多領域的人是一個很好的方法。

有人發明並發布了更好的機器學習技術,例如 attention 或 transformers。

接下來有研究生使用它,將臉部辨識率提高 5%。

然後一家小型新創公司,發布了一款可以更好地進行臉部辨識的應用程式。

然後政府使用該應用程式,研究市中心的步行模式和瀕臨滅絕的物種。

在法庭審計監控取得這些成功之後。

然後是一個鎮壓政府,用這種方法來辨識種族,然後發生種族滅絕。

沒有人直接犯下巨大的道德錯誤。但漸進的步驟,導致結果是可怕的。

下半場

有一個研究的例子,有很大的缺點,而且實際上沒有什麼好處。

確定種族,特別是少數民族。

例如中國維吾爾人的身分識別工作,維吾爾人是中國西部的穆斯林少數民族,自此以來,已有超過一百萬人被安置在集中營。

所以我認為這是一個非常有害的研究方向。

還有一些嘗試,建立一個分類器來嘗試識別某人的性別。

這也可能相當危險,因為在許多國家同性戀是違法的。

你可以花一兩個小時,上完 fast.ai 第一課後,就有能力建造這個東西。

任何人都可以做到。

人們經常問我,如何消除數據偏差或確保數據沒有偏差?

那是不可能的,所有數據都包含偏見。

最重要的是,了解你的數據集是如何創建的,以及它的局限性。這樣你就不會因為這種偏見而措手不及,但你永遠無法完全消除它。

雖然偏見和公平、問責制和透明度都很重要。

但它們不是一切。

這篇很棒的論文, Os Keyes 的《A Malching Proposal》。

演算法系統的倫理,影響了人機互動和對技術設計、開發和政策。

本文探討了一個重要的道德框架:公平、問責和透明度。

在解決與糧食安全和人口老化相關的各種社會問題的建議演算法中的應用。

使用各種標準化形式的演算法審計和評估,大大提高了演算法對 FAT 框架的遵守程度,從而形成了一個更道德和仁慈的系統。

我們討論這如何為其他研究人員或從業者提供指導,以確保演算法系統在其工作中獲得更好的道德結果。

假訊息(Disinformation)

「德州之心」是一個由俄羅斯控制的 Facebook 群組,旨在宣揚德克薩斯州的分裂國家,該群組傾向於將該州塑造為槍支和燒烤之地,有數十萬粉絲。他們在 Facebook 上發布的一則廣告宣布將於 2016 年 5 月 21 日中午舉行集會,以「制止德克薩斯州的伊斯蘭化」。

另一個由俄羅斯贊助的組織「美國穆斯林聯合會」在同一地點和時間宣傳「拯救伊斯蘭知識」集會。

當天,兩個團體組織的抗議者出現在休士頓市中心的崔維斯街,場面表面抗議又是反抗議。兩個群體之間的互動最終升級為對抗和言語攻擊。

俄羅斯的假資訊活動

它在非洲的六個不同國家開展業務,聲稱是當地新聞來源。

鼓勵人們加入他們的 WhatsApp 和 Telegram 群組,聘請當地人擔任記者。

很多內容不一定是假訊息,內容涉及文化、體育和當地天氣。

COVID-19

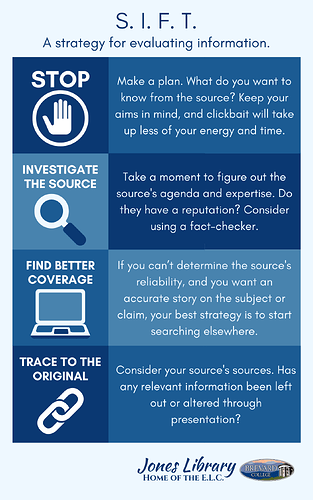

學習一些技能,這些技能將使你區分網路上的事實和虛構(以及介於兩者之間的所有內容)的能力,發生巨大的變化。

過去四年,我與學生和教師合作,找出學生和公民所缺乏的核心技能和習慣,這些技能和習慣使他們容易受到網路上錯誤訊息和虛假訊息的影響。

我們將它們組織成一個名為 SIFT 的模型:停止,調查 來源,尋找 更好的報導, 追溯 原始上下文。

-

Stop

當您感到強烈的情緒、驚訝或只是無法抑制地想要分享某些東西時…先停下來。

When you feel strong emotion, surprise, or just an irrepressible urge to share something… stop. Then use your other moves…

-

Investigate the Source

-

Find Better Coverage

-

Reverse image search (Coming soon)

-

Trace Claims, Quotes, and Media to the Original Context

美國 FCC 的網路中立性廢除調查

提交給 FCC 的 2千2百萬條評論中,只有不到 80萬條(3~4%)可以被認為是真正獨特的(非假造)。

網路上的偽身份

人工智慧的最新發展,已經將偽造文件、圖片、錄音、影片、線上身分變得前所未有的輕鬆。

額外的風險之一:它也損害了人們說真話的能力。

平台

當手機被用於詐騙時,需要承擔責任嗎?

車輛被用於恐怖攻擊,汽車公司要負責嗎?

這些平台是中立的,因為它們做了一些設計決策和執行決策、服務條款,以及如何執行這些規定。

在這些決定中,並不是每個人都必須遵守,如果沒有強制執行,言論自由只會改變誰被壓制。

私人公司擁有的權力是否令人不安?

評估時您可能會問的問題類型,甚至你如何評估一個項目是否符合道德。

後果論問題,誰會受到直接影響?誰會受到間接影響?

結果主義包括功利主義和共同利益。整體影響是否利大於弊?以及哪些類型的好處和壞處?

評估項目時可以使用的問題

我認為馬庫拉中心的建議是:這是一項適合團隊和團體的偉大活動。

Overview of Ethics in Tech Practice

Ethical Lenses

Framework for Ethical Decision Making

Ethics Toolkit

Ethics Toolkit includes seven tools:

-

Tool 1: Ethical Risk Sweeping

-

Tool 2: Ethical Pre-mortems and Post-mortems

-

Tool 3: Expanding the Ethical Circle

-

Tool 4: Case-based Analysis

-

Tool 5: Remembering the Ethical Benefits of Creative Work

-

Tool 6: Think About the Terrible People

-

Tool 7: Closing the Loop: Ethical Feedback and Iteration

Case Studies

Sample Design Workflow

Sample Workshop Slides

Best Ethical Practices in Technology

政策的需要

之前提到的,聯合國調查員發現 Facebook 在羅辛亞種族滅絕中發揮了決定性作用。

關於這方面我讀過最好的文章是 Timothy McLauchlin 寫的。

他對 Facebook 在緬甸的角色進行了超級、超級深入的探討。

人們在 2013 年、2014 年和 2015 年警告 Facebook 高階主管,該平台如何被用來傳播仇恨言論和煽動暴力。

盧安達種族滅絕期間播放的廣播,無線電廣播在盧安達種族滅絕中發揮了非常可怕和關鍵的作用。

知情人士表示,這不是 2020 年事後的諸葛亮。這個問題的規模很大,而且已經很明顯了。

儘管如此,在 2015 年,我相信 Facebook 甚至只有四名承包商會說緬甸語。

羅興亞人種族滅絕,這是一個持續存在的問題,這對我來說真的很令人震驚。

有這麼多的警告,有這麼多的人試圖提出,對此發出了警報,但採取的行動卻很少。

如何看待我們糾正偏見的機會

我確實認為我們應該努力尋求解決方案。

但我認為就在這一點上,更好的診斷和理解,我們面臨的複雜問題是有價值的工作。

有幾個人非常渴望看到您的完整道德課程。

它將在 2020年夏天的某個時候免費發布。